Industrie

How can we advance work routines?

In der heutigen Zeit werden die Anforderungen an Produktionsprozesse immer komplexer. Um diesen gerecht zu werden, werden zunehmend Roboter eingesetzt, die industrielle Produktionsschritte unzählige Male ohne Fehler wiederholen. Der Anwendungsfall U2 befasst sich mit der Interaktion von Mensch und Maschine im industriellen Kontext. Der Fokus liegt darauf zu zeigen, wie eine Maschine direkt vom Menschen lernen kann und das gelernte Verhalten an weitere Maschinen weitergibt, auch wenn diese in unterschiedlichen Kontexten stehen. Dabei soll das direkte Lernen vom Menschen die zeit- und kostenintensive Programmierung von Maschinen nach dem Stand der Technik ersetzen.

Mensch-zu-Maschine: Vom Experten lernen

Obwohl bereits viel über die Gestaltung von kollaborativen Arbeitszellen und Robotern geforscht wurde, gibt es noch große Herausforderungen zu bewältigen. Eine dieser Herausforderungen besteht darin, den Robotern alle erforderlichen Fähigkeiten zu vermitteln, damit sie an einem bestimmten Arbeitsplatz nützlich sind (Erlernen von Fähigkeiten). Die Art und Weise, wie moderne Roboter programmiert werden, unterscheidet sich stark von den mühsamen und zeitaufwändigen Prozessen früherer Systeme. So wird zum Beispiel das kinästhetische Lernen immer häufiger zur Programmierung kollaborativer Roboter eingesetzt, was eine viel intuitivere und effizientere Programmierung durch direkte Anleitung der Roboter ermöglicht. Der Roboter kann dann auf der gezeigten Aufgabe aufbauen und sie mit Hilfe geeigneter Lernmethoden selbstständig optimieren. Beispiele für solche Aufgaben sind Schrauben/Bohren, Stanzen, Schleifen, Hämmern oder Schweißen. Je nach Anwendungsszenario können die Aufgaben vielfältig variiert werden, z. B. in der Elektronikmontage oder in der Automobilindustrie.

Demonstrator Cocktail Robot

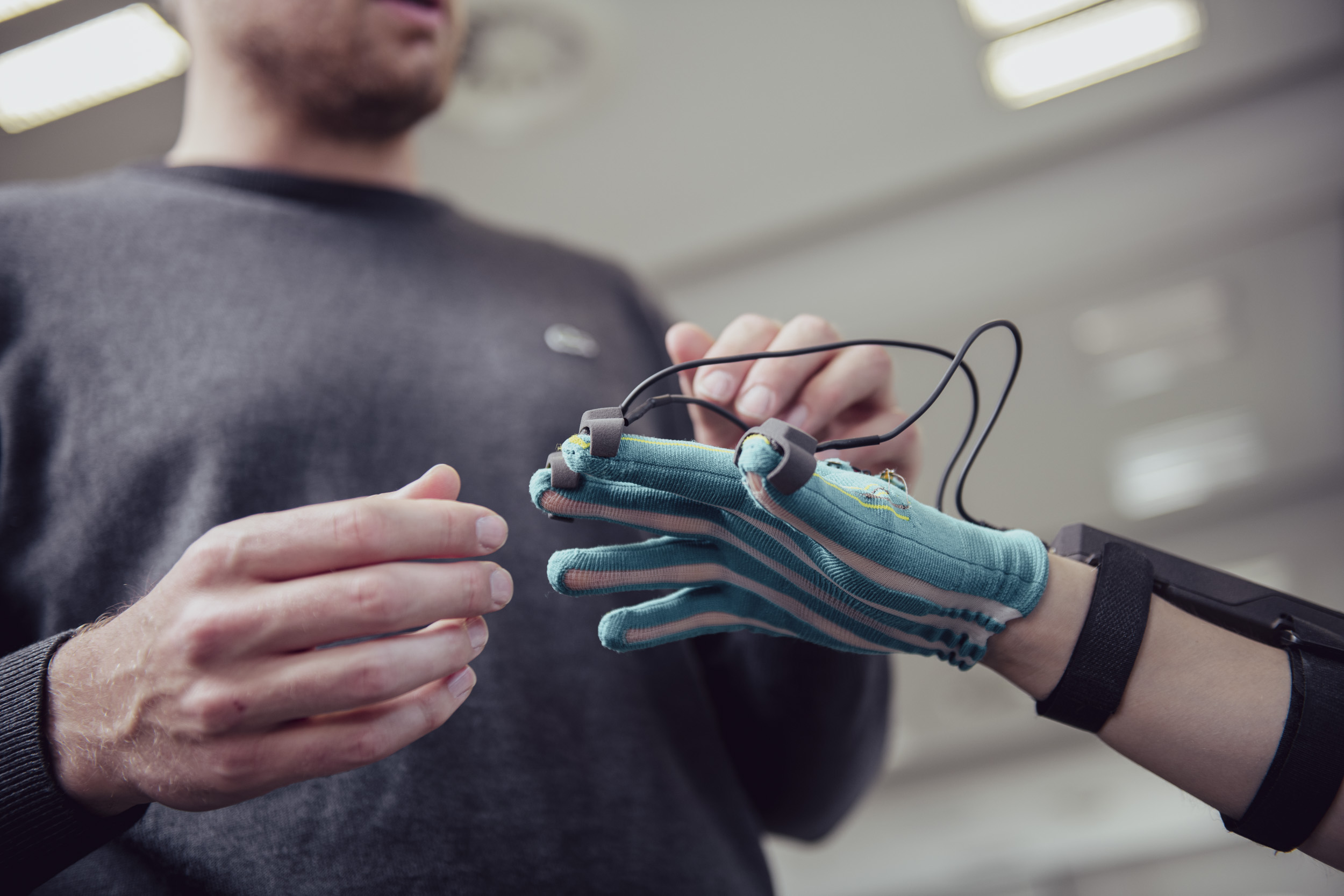

Der Roboter hilft bei der Herstellung von Cocktails und wird durch Gesten und Berührungen gesteuert. Ein digitaler Handschuh mit mehreren Positionssensoren und die Drehmomentsensoren in den Gelenken des Roboters werden verwendet, um intuitive Steuerungsmethoden eines Menschen, wie Gesten und Berührungen, zu interpretieren. Der Demonstrator zeigt, dass es möglich ist, Geräte zuverlässig über Handgesten zu steuern. Diese Technologie ermöglicht eine leichtere Übernahme neuer Technologien, die im industriellen Kontext wichtig wären.

Aufräum-Demonstrator

Der Immersive Sorting Demonstrator zeigt die Fähigkeiten unseres Cobotic Frameworks. Die Roboter nehmen Bausteine auf und legen sie in Behälter, während der/die Benutzer/in ein VR-Headset trägt. Mit diesem Headset kann der-/diejenige mehrere Roboter steuern, die in verschiedenen Umgebungen und Einstellungen arbeiten. Die Fernsteuerung des Roboters ermöglicht eine höhere Produktivität, die in der modernen industriellen Produktion eine wesentliche Kennzahl ist.

Schere Stein Papier Demonstrator

Der Schere-Stein-Papier-Demonstrator ermöglicht dem/der User/in eine natürliche Interaktion mit einem Roboter. Die Benutzer:innen tragen den CeTI-Handschuh, der Fingerbewegungen erfasst, Gesten (Stein, Papier, Schere) erkennt und diese Gesten schließlich an die Roboterhand weiterleitet. Die spielerische Herangehensweise an das Spiel Schere, Stein, Papier dient als niedrigschwelliger Einstieg für Besucher öffentlicher Veranstaltungen. Das Spiel wurde absichtlich so gestaltet, dass niemand gewinnen oder verlieren kann. Die Besucher:innen sollten die Erfahrung machen, die Bewegungen des Roboters zu kontrollieren, und den Roboter nicht als Gegner, sondern als freundlichen Spielkameraden wahrnehmen.

TracePen Demonstrator

Bei der Demonstration TracePen handelt es sich um einen Roboter, der die Bewegungen von Menschen nachahmen kann. Dazu nutzt der Roboter die Software des Start-ups wandelbotsBei der Demonstration TracePen handelt es sich um einen Roboter, der die Bewegungen von Menschen nachahmen kann. Dazu nutzt der Roboter die Software des Start-ups wandelbots, die es dem Roboterarm ermöglicht, vom Menschen gelernte Bewegungen mit Hilfe des TracePen zu wiederholen. Der/die Benutzer/in kann dem Roboter mit Hilfe des TracePen einfache Zeichnungen zeigen - der Roboter führt dann die gleiche Zeichenbewegung mit einem echten Stift aus. Dies zeigt, dass die Roboterprogrammierung mit Hilfe der Demonstration stark vereinfacht wird, was in der Fertigungsindustrie sehr gut ankommt.

Machine-to-human: Bewertung durch den Experten

Der taktile Roboter dient als multimodales Überwachungsgerät, das dem Menschen über intelligente Wearables ein vollständiges audiovisuelles und taktiles Feedback gibt. Als Beobachter:in im Avatar-Modus kann der Mensch die Kontaktsituation des angeschlossenen Roboters direkt erleben. Anhand dieses Feedbacks können programmierte oder sogar gelernte Aufgaben evaluiert werden. Darüber hinaus ermöglicht die Verbindung über das taktile Internet, dass komplexe Aufgaben von Robotern erlernt und später vom Menschen erlebt werden können.

Fingertac Demonstrator

Der Fingertac-Demonstrator zeigt, wie intuitive Robotersteuerung mit taktiler Rückmeldung funktioniert. Der/die Benutzer/in kann einen Roboterarm durch einen Textilhandschuh mit Fingertac (vibrotaktiles Feedback) steuern. Durch das Erleben des Feedbacks an den Fingerspitzen wird der/die Benutzer/in intuitiv durch definierte Aufgaben geführt. Die Vorteile des vibrotaktilen Feedbacks bei einer ferngesteuerten Roboterbedienung sind die Erleichterung der Robotersteuerung und eine erhöhte Arbeitssicherheit. Diese werden im Rahmen einer noch in der Entwicklung befindlichen Chemielaboranwendung aufgezeigt.

Haptischer Ultraschall-Demonstrator

Ziel des Haptic Ultrasound Demonstrators ist es, eine berührungslose haptische Steuerung in einer virtuellen Umgebung zu zeigen, z. B. taktile Hinweise auf physische Objekte oder Kraftrückmeldung unter einer Handfläche für dynamische Bedingungen. Diese immersiven Empfindungen können das haptische Erlebnis verbessern, zum Beispiel bei der Steuerung eines Roboters über die virtuelle Realität.

Kooperative Forschungsprojekte

Das Zusammenleben von Robotern und Menschen erfordert unterschiedliche Technologien, die in verschiedenen Forschungsprojekten getestet werden, die sich gegenseitig ergänzen und aufeinander aufbauen.

Erfassung und Modellierung der Welt

Mit der Popularität von RGB-D-Kameras wurde eine Vielzahl von Systemen zur 3D-Rekonstruktion im laufenden Betrieb vorgeschlagen. Für sichere Übergabesituationen zwischen Menschen und Robotern sind die Präzision und die Latenzzeit der aktuellen 3D-Erfassungs- und Verfolgungsansätze jedoch immer noch unzureichend. Immersive Modellierung ist ein vielversprechender Weg, um 3D-Objekte in VR/AR zu kennzeichnen, zu segmentieren und semantische Eigenschaften zu extrahieren. Daher schlagen wir ein mehrschichtiges immersives 3D-Scanning-Framework vor, um eine AR/VR-Umgebung für verschiedene Anwendungen zu schaffen. Das Framework basiert auf der Strukturierung von Punktwolken in sinnvolle Teile. Die Verknüpfung der physischen und der virtuellen Welt führt zur Entwicklung und Umsetzung einer natürlichen Interaktion zwischen Mensch und Maschine.

Textile Sensoren und Aktuatoren

Die Textiltechnologie am CeTI befasst sich zum Beispiel mit der Funktionalität von Textilien und der Stricktechnologie. Sie bietet eine breite Palette von Möglichkeiten zur Verbesserung von Textilien für verschiedene Anwendungen, die ständig erweitert wird. Die Forschung konzentriert sich auch auf textilbasierte Sensoren und Aktuatoren und deren leitfähiges Verhalten. Diese Sensoren und Aktuatoren bringen viele vorteilhafte Eigenschaften für Wearables mit sich. Wearables, intelligente Textilien und Geräte sind die Hardwarebasis für Softwareentwicklung und psychologische Untersuchungen. Der CeTI-Handschuh und das Smart Kinesiotape sind das Ergebnis von Forschungen, bei denen textil-physikalische und elektromechanische Untersuchungen zusammenkommen.

Interaktion der menschlichen Hand

Die menschliche Hand ist ein außerordentlich komplexes System. Es ist wichtig, genau zu verstehen, wie die menschliche Hand mit Objekten interagiert. Diese Informationen werden verwendet, um die Anforderungen zu ermitteln, die notwendig sind, um Roboterhände zu bauen, die in der Lage sind, die analysierten Szenarien - zunächst Greifhaltungen - auszuführen. Die Genauigkeit des Rahmens für die Darstellung der menschlichen Interaktion wird durch die Beobachtung der aufgezeichneten Kontaktflächen und den Vergleich mit den Daten des Bewegungsverfolgungssystems bewertet.